|

|

原标题:DeepMind“反向”搭建Transformer办法火了:由可解释顺序设计AI,名目已开源

萧箫 发自 凹非寺

量子位 | 大众号 QbitAI

先搭个模型,成果好就试着解释它,是咱们常见的AI设计套路。

但,有人曾经受够了这样“稀里糊涂”的流程——

既然人类老是试图解释AI模型,那为何不克不及反过去,间接用 看得懂的顺序来设计AI模型权重呢?

这样做出来的模型,既晋升了它的 可解释性,又升高了设计架构的繁杂度。

aqtp2xcplgh.jpg

这是DeepMind针对Transformer模型设计的最新工具,被po到网上后爆火:

5e34bweu5o4.jpg

有网友诧异表现:

这真无意思。它也许是第一个能将代码 (软件1.0)变模型 (软件2.0)的零碎。

展开全文 这真无意思。它也许是第一个能将代码 (软件1.0)变模型 (软件2.0)的零碎。

av0naqcvdji.jpg

所以它到底是如何完成的?

将可读代码转变为AI权重的“编译器”

这个将可读性较高的代码“翻译”成Transformer模型的工具,名叫 Tracr。

详细来讲,它有点像是一个“ 编译器”,晓得将一种名叫RASP (Restricted Access Sequence Processing Language)的编程言语转换成Transformer模型权重。

RASP,是此前在ICLR 2021一篇论文中提出的“编程言语”,专门按照Transformer架构 (编解码器-留意力机制等)设计。

Tracr则在此根底上更进一步,不只简略优化了原本的RASP言语,并且能将基于RASP编写的顺序很好地转换为Transformer模型的权重。

详细来讲,Tracr会先将“编程言语”RASP转换成“汇编言语”craft,后者表现向量空间以及此间的对应操作,再进一步地,将craft转变为“机器码”模型权重。

05t22p5zx4j.jpg

详细完成进程如下,一共分为5步:

据一作引见,Tracr最大的亮点在于,能够“从0开始搭建你本人的Transformer模型”。

还提出了配套紧缩办法

不外,基于Tracr打造的模型可能效力很低,因此作者们又提出了一种配套的“ 紧缩”办法。

基于案例来看,这类办法不只能让Tracr模型更高效,并且允许将D维特点紧缩到小于D维的特点空间中。

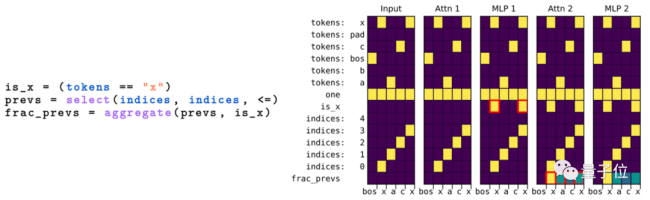

例如这是基于RASP言语编写的顺序示例:

在对模型进行紧缩后,一样能很好地实现原来的工作,且成果相差不大:

hsepiucxml5.jpg

与此同时也能包管一个不错的精度:

bnlc5afjnlv.jpg

目前对应的Tracr模型曾经开源,感兴致的小火伴们能够去查看一波~

作者引见

论文作者们分别来自DeepMind和苏黎世联邦理工学院。

一作David Lindner,苏黎世联邦理工学院在读博士生,这份任务是他在DeepMind实习期间实现,目前感兴致的钻研标的目的是AI鲁棒性、强化学习等。

1js0hs0nqhs.jpg

你想好用它设计一个怎么样的Transformer模型了吗?

论文地址:

http://arxiv.org/abs/2301.05062

名目地址:

http://github.com/deepmind/tracr

— 完—

「人工智能」、「智能汽车」微信社群邀你参加!

欢送关注人工智能、智能汽车的小火伴们参加交流群,与AI从业者交流、切磋,不错过最新行业开展&技术停顿。

PS. 加好友请务必备注您的姓名-公司-职位噢 ~

点这里 ?关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

科技前沿停顿日日相见 ~ |

|